Seis princípios para avaliar cientistas para contratação, promoção e posse

As conseqüências negativas de confiar demais nas métricas para avaliar a qualidade da pesquisa são bem conhecidas, potencialmente fomentando práticas prejudiciais à pesquisa científica, como p-hacking, ciência de salames ou relatórios seletivos. A cultura “florescer ou perecer” definida por essas métricas, por sua vez, impulsiona o sistema de avanço na carreira acadêmica, um sistema que a evidência empírica mostrou ser problemática e que não leva em conta adequadamente o impacto social e mais amplo. Para resolver este problema sistêmico, Florian Naudet , John Pa Ioannidis , Frank Miedema , Ioana A. Cristea , Steven N. Goodman e David Moher apresentar seis princípios para avaliar os cientistas quanto à contratação, promoção e posse.

Instituições médicas acadêmicas, ao contratar ou promover o corpo docente que, esperam, levarão a ciência adiante de maneira impactante, são confrontadas com um problema familiar: é difícil prever qual contribuição científica será maior ou atender aos valores e padrões de uma instituição. Alguns aspectos do trabalho de um cientista são facilmente determinados e quantificados, como o número de artigos publicados. No entanto, o volume de publicações não mede “qualidade”, se por qualidade queremos dizer ciência substantiva e impactante que aborda questões valiosas e é confiável o suficiente para ser construída.

Reconhecendo isso, muitas instituições aumentam o número de publicações com medidas que acreditam capturar melhor o julgamento da comunidade científica sobre o valor da pesquisa. O fator de impacto da revista (JIF) é talvez o mais conhecido e mais amplamente utilizado de tais métricas. O JIF em um determinado ano é o número médio de citações de artigos de pesquisa naquela revista nos dois anos anteriores. Como números de publicação, é fácil de medir, mas pode falhar em capturar o que uma instituição valoriza. Por exemplo, na Universidade Rennes 1, o comitê de avaliação científica da faculdade de medicina avalia os candidatos com um fator de impacto “médio” (a média do JIF de todos os trabalhos publicados) e a contratação de professores exige publicações em periódicos com o JIF mais alto. Eles tentam tornar isso mais granular, usando também uma pontuação que tenta corrigir o JIF para o campo de pesquisa e a classificação do autor. (Esta pontuação, “Système d'Interrogation, de Gestion et d'Analyse des Publications Scientifiques”, SIGAPS, não está disponível publicamente). Na China, Qatar, Arábia Saudita, entre outros países, os cientistas recebem bônus monetários para artigos de pesquisa publicados em periódicos de alto JIF , como a Nature .

Entender o valor de um trabalho requer uma avaliação cuidadosa. A leitura de alguns artigos que melhor caracterizam o corpus da pesquisa de um cientista oferece insights sobre sua qualidade que não podem ser capturados por métricas de JIF. O JIF fornece informações sobre a influência da citação de um periódico inteiro, mas é muito menos informativo para a avaliação de uma publicação individual e ainda menos útil para a avaliação dos autores desses artigos. As distribuições de citações de periódicos são altamente distorcidas, com uma pequena porcentagem de artigos representando uma grande maioria do total de citações, o que significa que a grande maioria dos artigos, mesmo em periódicos de alto JIF, terá relativamente poucas citações.. Além disso, o fenômeno do viés de publicação existe nos periódicos mais altos do JIF, em que a significância estatística dos resultados afetará as perspectivas de publicação de estudos de qualidade igual. Indiscutivelmente, o achado mais importante do projeto de reprodutibilidade da The Open Science Collaboration , que escolheu aleatoriamente 100 estudos de três principais periódicos no campo, é que com tamanhos de amostra medianos excessivamente modestos (medianas de 23 a 76), 97% desses estudos relataram resultados estatisticamente significativos. Claramente, os periódicos estavam usando a significância como um critério de publicação, e os autores sabiam disso.

Isso nos traz uma característica crítica nesses sistemas de avaliação que ameaçam o empreendimento científico, incorporado na Lei de Goodhart (ou seja, deixa de ser uma medida válida quando se torna um alvo de otimização). Isso acontece quando a medida pode ser manipulada por aqueles que está medindo - conhecida como “jogo” - desvalorizando a medida e produzindo consequências prejudiciais não intencionais. No caso da pesquisa científica, essas práticas não intencionais (mas previsíveis) incluem p-hacking, ciência de salame, métodos desleixados, relatórios seletivos, baixa transparência, extorsão de resultados espúrios (também conhecidos como spin e hype) e uma ampla gama de outras pesquisas prejudiciais. práticas que promovem publicação e carreiras, mas não necessariamente pesquisa reprodutível. Desta forma, a cultura “florescer ou perecer” definida por essas métricas, por sua vez impulsiona o sistema de progressão na carreira e sobrevivência pessoal na academia que contribui para a crise de reprodutibilidade e qualidade sub-ótima do registro de publicações científicas. O problema descrito acima é de natureza sistêmica e não uma questão de mau comportamento individual antiético.

Há abundante evidência empírica para mostrar que o atual sistema de incentivo e recompensa internacionalmente dominante, ainda usado pela maioria das partes interessadas, incluindo grandes financiadores, na academia é problemático. Os cientistas que trabalham em áreas de pesquisa que não cedem facilmente documentos de “alto impacto”, mas que têm alto impacto social e lidam com necessidades prementes, estão subvalorizados. Além disso, os cientistas que fazem pesquisas significativas com fundos limitados são prejudicados quando solicitam financiamento, em comparação com cientistas com registros de financiamento mais abrangentes, um forte indicador de financiamento futuro . Os indicadores utilizados para avaliar pesquisas e (equipes de) pesquisadores por financiadores, universidades e institutos em decisões de promoção e posse também devem levar em conta o impacto social e mais amplo.

Para abordar essas questões, o Centro de Inovação em Meta-Pesquisa da Stanford (METRICS) convocou um workshop de um dia em janeiro de 2017 em Washington DC, para discutir e propor estratégias para contratar, promover e manter os cientistas. Era composto por 22 pessoas que representavam diferentes grupos de partes interessadas de vários países (reitores de medicina, financiadores públicos e fundadores, especialistas em políticas de saúde, sociólogos e cientistas individuais).

Os resultados desse workshop foram resumidos em uma perspectiva recente , na qual descrevemos uma extensa, mas não exaustiva, lista de propostas atuais destinadas a alinhar avaliações de cientistas com comportamentos científicos desejáveis. Algumas grandes iniciativas estão ganhando força. Por exemplo, a Declaração de San Francisco sobre Avaliação de Pesquisa ( DORA ) foi endossada por milhares de cientistas e centenas de instituições acadêmicas em todo o mundo. Ele defende “ uma necessidade urgente de melhorar a forma como a pesquisa científica é avaliada e pede que cientistas, financiadores, instituições e editoras renunciem ao uso de JIFs para julgar pesquisadores individuais ”. Outras propostas ainda são apenas idéias sem qualquer implementação ainda.

No University Medical Center Utrecht, os compromissos com o impacto social e clínico em colaboração com as comunidades locais e nacionais são usados como indicadores relevantes para a avaliação de cientistas . A UMC Utrecht está colaborando com o Centro de Estudos de Ciência e Tecnologia de Leiden para avaliar o efeito dessas intervenções.

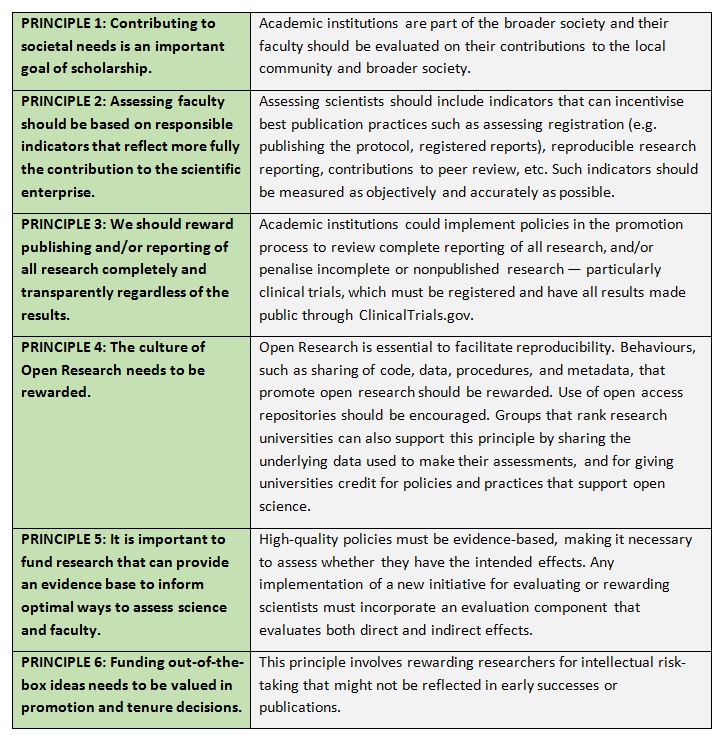

Os participantes deste workshop endossaram o seguinte conjunto de princípios, resumidos na perspectiva:

Embora esses princípios não sejam novos, agora há um surto de atividades se preparando para usá-las na academia. Os líderes do G7 indicaram recentemente a necessidade de mudanças na forma como os cientistas são avaliados . A Europa pode estar à frente da curva ao endossar e implementar mudanças. O novo programa-quadro Horizon Europe adota Open Science e Open Innovation como dois dos seus três pilares. Isso exige um esquema de avaliação mais inclusivo de pesquisa e pesquisadores, compatível com o descrito aqui. A Comissão editou orientações para ajudar os Estados-Membros da UE na transição para o Open Science (incluindo o conceito de que os dados são “JUSOS” - “Findable, Accessible, Interoperable and Reusable”). Eles estão se movendo em direção a um CV estruturado que incluiria Indicadores Responsáveis para Avaliar os Cientistas (RIAS) e outras informações relacionadas.

Esses esforços se concentram principalmente em práticas científicas abertas. Mais trabalho precisa ser feito por instituições, pesquisadores e formuladores de políticas para alcançar o Princípio 1, como definir a contribuição de um cientista para as necessidades da sociedade. Isso poderia exigir que as universidades modificassem suas políticas internas de avaliação para incorporar explicitamente suas missões de disseminação de conhecimento e impacto social , que muitas vezes não são explicitamente articuladas. Essas definições e avaliações da missão devem incluir um amplo espectro de avaliadores, incluindo o público ou seus representantes. E qualquer movimento nesse sentido, como em todas as iniciativas acima, exigirá um esquema para monitorar os resultados positivos e negativos.

Estamos em um momento crucial no movimento de reforma da pesquisa; um movimento que atravessa fronteiras disciplinares e nacionais. Há uma janela de oportunidade agora para fazer mudanças que antes eram consideradas impossíveis. É importante que aproveitemos ao máximo essa oportunidade, alcançando o equilíbrio certo entre novas abordagens promissoras e o possível dano em algumas situações de abandono das ferramentas de avaliação atuais, que podem servir como um amortecedor parcial contra o avanço baseado em conexões pessoais ou reputação declarada. Precisamos fazer mudanças com os mesmos padrões minuciosos de cuidado que aplicamos à própria ciência.

Esta postagem de blog é baseada no artigo dos autores, “ Avaliação de cientistas para contratação, promoção e estabilidade ”, publicado na revista PLoS Biology (DOI: 10.1371 / journal.pbio.2004089).

Sobre os autores:

Florian Naudet é psiquiatra, meta-pesquisador e ex-pós-doutorado na METRICS. Atualmente, ele está lecionando Terapêutica na Universidade Rennes 1, na França. Seus interesses de pesquisa estão avaliando e desenvolvendo soluções metodológicas para avaliar tratamentos em pacientes, principalmente, mas não exclusivos, em pesquisa psiquiátrica. Ele tem um forte interesse em estudar resíduos de pesquisa e práticas de compartilhamento de dados. Ele trabalhou nas áreas de farmacologia clínica, metodologia de pesquisa, epidemiologia e neurociências. Seu ORCID iD é 0000-0003-3760-3801 .

John PA Ioannidis éo Professor CF Rehnborg em Prevenção de Doenças e Professor de Medicina, de Pesquisa e Política de Saúde, e de Estatística. O Dr. Ioannidis é reconhecido internacionalmente como líder em estudos empíricos que avaliam vieses, replicação e confiabilidade de descobertas de pesquisas em biomedicina e além. Ele atuou como presidente da Society for Research Synthesis Methodology, consultor sênior de integração do conhecimento no Instituto Nacional do Câncer, membro do conselho editorial de 30 principais periódicos internacionais e editor-chefe do European Journal of Clinical Investigation. Ele é um dos cientistas mais citados em todo o mundo. Seu artigo na revista PLoS Medicine, “Por que a maioria dos resultados de pesquisas publicadas é falso”, tem sido o artigo mais acessado na história da Public Library of Science, com mais de 1 milhão de acessos.

Frank Miedema é professor de imunologia e reitor / vice-presidente do Conselho Executivo do University Medical Center Utrecht, Holanda. Por mais de 20 anos, ele trabalhou na patogênese do HIV, especialmente o papel da imunidade celular anti-HIV na proteção de doenças. Como reitor, ele inspirou o desenvolvimento de uma nova estratégia da UMC Utrecht, com foco no impacto social dos programas de pesquisa e no envolvimento das partes interessadas. Juntamente com um grupo de cientistas ilustres, ele lançou a iniciativa Ciência em Transição na Holanda. A Ciência em Transição argumenta que a ciência precisa de uma reforma fundamental. A avaliação da qualidade bibliométrica deve ser substituída por análises alternativas específicas do domínio. Além disso, os cientistas devem envolver as partes interessadas da sociedade na formulação de sua agenda de pesquisa.

Ioana Cristea é Professora Associada da Babes-Bolyai University, Romênia e ex-bolsista visitante da Fulbright na METRICS. Ela é treinada como psicóloga clínica e trabalhou anteriormente nas universidades de Pisa e Padova, na Itália. Sua pesquisa se concentra em avaliar criticamente a eficácia de várias intervenções psicológicas e farmacológicas para transtornos mentais, bem como o papel dos conflitos financeiros e não financeiros de interesse. Mais genericamente, seu trabalho inclui um foco em questões relacionadas à transparência, rigor e desperdício na pesquisa clínica e na pesquisa psicológica em geral, usando abordagens quantitativas e mistas.

Steven N. Goodman é Decano Associado de Pesquisa Clínica e Translacional e Professor de Medicina e de Pesquisa e Política de Saúde, dirigindo os programas de treinamento CTSA da Stanford em métodos de pesquisa médica e atuando como chefe da Divisão de Epidemiologia. Ele é editor sênior de estatística do Annals of Internal Medicine desde 1987 e foi editor de Clinical Trials: Journal of the Society for Clinical Trials de 2004-2013. Ele é vice-presidente do Comitê de Metodologia do Instituto de Pesquisa de Resultados Centrados no Paciente (PCORI) e, desde 2004, é assessor científico do Programa Nacional de Avaliação da Tecnologia Blue Cross-Blue Shield.

David Moher é um cientista sênior do Programa de Epidemiologia Clínica do Ottawa Hospital Research Institute, onde dirige o Center for Journalology . O Dr. Moher é também Professor Associado da Escola de Epidemiologia e Saúde Pública da Universidade de Ottawa, onde exerce uma cadeira de pesquisa universitária. Ele lidera um programa de pesquisa ativo que investiga: como reduzir o desperdício e aumentar o valor da pesquisa biomédica; diretrizes de relato biomédico; revistas e editores predatórios; competências essenciais para editores de periódicos científicos; ciência aberta; e como avaliar os cientistas. Seu ORCID iD é: 0000-0003-2434-4206 .

Esta matéria foi publicada originalmente no LSE Impact Blog.

- noticias

Conteúdo relacionado

Indução e avaliação dos impactos de pesquisa

- 2498 leituras